-

しかし既知のデータもすべて綺麗にこの式に従うわけではない

-

各サンプル(既知のデータのこと)の番目について次のような式を考えられる

-

が番目のサンプルの誤差あるいはノイズを表している

-

切片は?2 次以上は考えられないの?

- などとしてやれば良い

- これはグラフだと曲線になるけど「線形回帰」という

どうやって w を学習させるの?

- 詳しくはあとでやりますが…

- 代表的なのは最小二乗法

- 既知のデータについて 2 乗誤差が最小になるようなを求める

- (しかし、これは「ベイズ的」ではない…)

- (ベイズ推論はもっと面白い方法で良いを求める)

目次 1

- 機械学習って何?

- 線形回帰

- 分類

- その他の機械学習

- 確率の基本

- 確率分布・Bayes の定理

- 具体例 (2 つの袋の赤玉/白玉)

- 逐次推論

回帰から分類へ

- 分類(classification)も機械学習においてよく出てくるタスク

- のように離散的な値を取る

- 例えば 0 が陰性、1 が陽性みたいな

- 多クラス(0: 陰性, 1: 軽症, 2: 重症みたいな)は後で

- 線形回帰では連続値を予測した

- 離散的な値はどう予測する?

連続値を確率とみなす

- 回帰で求めた値(とします)は実数全体を取りうるのでややこしい

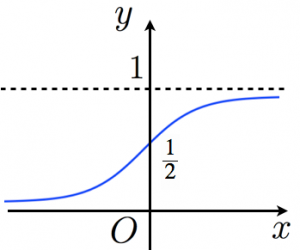

- みたいな関数によってをに移せれば簡単

- を「クラス 1 に分類される確率」として考えられる

- なら、そうでないならとすればよい

- どんな関数が良いだろう…

Sigmoid function

- 有名な関数: シグモイド関数(sigmoid function)

- とか表記されることもある

ここまでを数式でまとめる

- 今やりたいのは

- 入力が与えられて

- 出力を求めたい

- 線形回帰によりを求める

- 既知のデータから良い感じのを求めて、未知のデータにも適用

- をとって、0.5 以上なら 1、そうでないなら 0

多クラス分類

- 0: 陰性, 1: 軽症, 2: 重症 みたいな分類をしたい

- 非医学で言えば、手書き数字の認識(MNIST)などが有名

- 各クラスごとの確率を出す

- 先ほどの例では、最終的な出力は「クラス 1 に分類される確率」

- k クラス分類では出力を次元として、番目の成分が「クラスに分類される確率」を表すことにする

- 「ことにする」 = そのようにモデルを train する

softmax 関数

- この f を softmax 関数という

- が線形回帰の出力で、はその値から、番目のクラスの確率を表す値を求める関数

- について総和を取ると 1 になる (確率として都合の良い性質)

- sigmoid 関数の拡張

- 2 変数の場合について softmax を計算して、式変形によって sigmoid 関数の形にしてみると分かる

フォローしてますか?

- この章では全てを理解する必要はありませんが、

- なにか質問があればお願いします。

- ここからは定性的なざっくりとした話が続きます

目次 1

- 機械学習って何?

- 線形回帰

- 分類

- その他の機械学習

- 確率の基本

- 確率分布・Bayes の定理

- 具体例 (2 つの袋の赤玉/白玉)

- 逐次推論

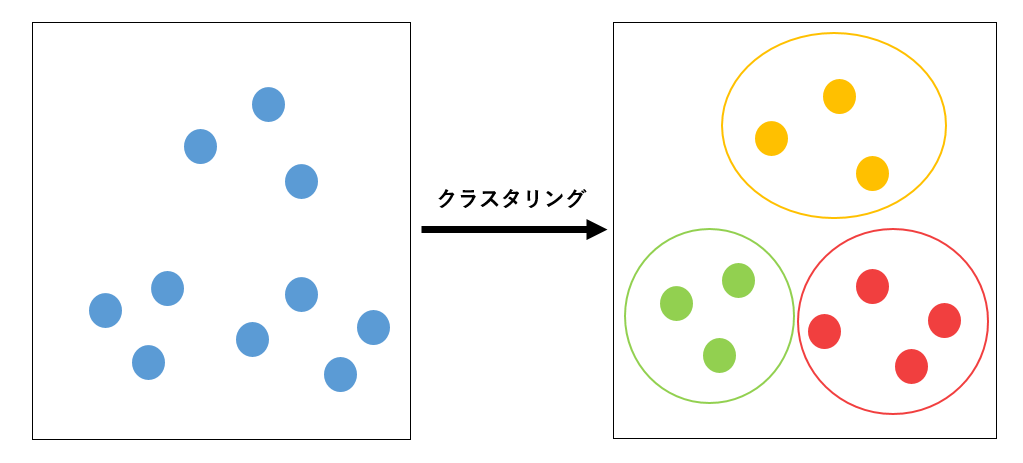

クラスタリング

- N 個のデータを K 個の集合に分ける

- 今までの分類タスクとの違いは?

- クラスタリングは事前の学習をせず、いきなり未知のデータが与えられてそれを良い感じに分ける(教師なし学習)

線形次元削減 (動機)

- データが増えれば増えるほどより良い予測ができる??

- 次元が増えるほど学習が難しくなる (次元の呪い)

- 次元を減らしたい

- けど、重要なデータを削ったらもちろん精度は落ちてしまう

つまり…

- 次元の重要度が高いものは残したい、低いものは消し去りたい

- 高血圧のリスク予測に「塩分摂取量」は大事そうだけど、「使っている鉛筆の硬度」を入れても精度は上がらなそう

線形次元削減

元のデータ を重みと削減したデータを用いて近似したい

- ではなくが元のデータ(既知)ということに注意が必要

- はに含まれるデータの本質を抽出

- 線形回帰と式が似ている

- 注意: の特徴量から重要なのを「選び取っている」のではなく、新しい特徴量を作っている

どうやってを求めるの?

- との誤差が最小になるようにとか

- ベイズ的な方法とか

- 詳しくは後の章で

他にもいろいろ機械学習 (余談)

- おすすめ商品

- 自動で質問に答える

- 人工的に画像を作り出す

などなど

機械学習の 2 つのアプローチ

- ツールボックス

- 様々なアルゴリズムを試して性能を高めようとする

- モデリング

- データの仮定・制約から数理的なモデルを構築 (モデリング)

- このデータは正規分布に従うとか、ポアソン分布に従うとか

- そのモデルのパラメータを推論によって求める (推論)

- 正規分布なら平均・標準偏差

- データの仮定・制約から数理的なモデルを構築 (モデリング)

- ディープラーニングではツールボックス型が多いが、この本ではモデリングを扱う

目次 1

- 機械学習って何?

- 線形回帰

- 分類

- その他の機械学習

- 確率の基本

- 確率分布・Bayes の定理

- 具体例 (2 つの袋の赤玉/白玉)

- 逐次推論

確率の基本

- いよいよ確率の基本に入っていきます

- 1 年生の頃にやっていたことなのですが、当然、忘れているので適宜復習しながら進めていきましょう。

離散と連続

- 離散: -3, 0, 1, 4,のように飛び飛びの値

- 連続: 実数全体を取る。0 と 1 の間にも無数の値が存在する

記法の復習

- : 確率変数がに等しくなる確率

- : 確率変数が以下になる確率

- : 「確率変数がに等しく かつ 確率変数がに等しい」確率

- :「確率変数はに等しい」ということが分かっている状況下での確率変数がに等しい確率

目次 1

- 機械学習って何?

- 線形回帰

- 分類

- その他の機械学習

- 確率の基本

- 確率分布・Bayes の定理

- 具体例 (2 つの袋の赤玉/白玉)

- 逐次推論

離散確率分布を表す確率質量関数

- 簡単に言うと、はを表す

- 性質(?)

- 逆にこれらの性質を満たすものを確率質量関数と定義する (後に出てくる連続型分布と対応させるため)

連続型確率分布(確率密度関数)

定義

関数で、かつ

となるもの

- 確率なんだから 0 以上で、全ての場合を足したら 1 になるべき

- 連続なので難しいけど、がちょうどその値を取ったときの確率

確率密度関数(1 変数関数の場合)

-

1 変数は去年?やった

-

多変数でも雰囲気は同じ

-

勘違い

- はと同じだ!→ 違います

- 連続値なので面積で考える。ある 1 点のみの値はあまり確率的な意味合いを持たない

連続と離散をあわせて考える

結局、離散型確率分布の確率質量関数は、連続型確率分布の確率密度関数の積分(連続的な和)をシグマ(離散的な和)に変えただけです。

よって、今後の議論では積分を用いて連続型確率分布について考えますが、同様の議論が離散型確率分布にも適当可能です。

同時分布

- 2 つの変数に対応する確率分布

周辺化

- 周辺化: 一方の変数を除去する

- x かつ y の確率が全ての x, y について分かっている条件下で

- の確率を知りたいなら、全てのについて、それらを足し合わせれば良い

- このを周辺分布という

条件付き分布

- のこと

- これはについての確率分布である

- の情報はパラメータとして作用し、の分布の特性を決める

- 詳しくは先でやりますが、「既知のデータ y が与えられたら、x の分布は元のからより妥当なに更新される」みたいな感じ

Bayes の定理

- を両辺に掛ければ両辺がで等しくなる

- この式自体は割と当たり前のことを言ってるだけ

- しかし、ベイズ推論ではをを使って表したいことが頻発するのでそういう意味で重要

独立性

- 「x と y が独立である」とは

- あるいは、

- すなわち、の情報が加わっても役に立たないということ

目次 1

- 機械学習って何?

- 線形回帰

- 分類

- その他の機械学習

- 確率の基本

- 確率分布・Bayes の定理

- 具体例 (2 つの袋の赤玉/白玉)

- 逐次推論

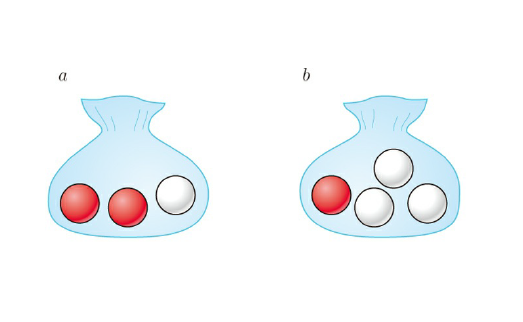

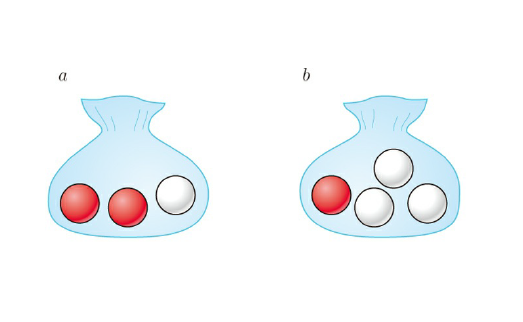

問題設定

状況: 2 つの袋 a, b があり、それぞれに赤と白の玉が入っている

-

a には赤 2 コ, 白 1 コ

-

b には赤 1 コ, 白 3 コ

操作: -

まず 1/2 の確率で a, b の袋を選ぶ

-

その後にその袋から玉を取り出す

袋の選択

- 袋 a が選ばれることを, 袋 b が選ばれることをとすると、

赤白玉の選択

- 赤玉が取り出されることを, 白玉を

- 袋 a が選ばれたとき、

- 袋 b が選ばれたとき、

同時分布を求める

が使える

袋 a を選択し、かつ、赤玉を取り出す確率は、

- これを求めること自体は簡単だと思いますが、今回の内容である「同時分布」「条件付き分布」といった概念と関連付けていきましょう!

周辺分布を求める

- 周辺分布?→をすべてのについて足し合わせてに

- 「選んだ袋に関わらず赤 or 白玉が出る確率」を求めることに相当

- 離散なのでシグマを使ったが、連続ならを使う

- はと考えると分かりやすいかも

Bayes の定理を使う

メインテーマ!

- Bayes の定理はをを用いて表せる

- 取り出した玉が分かっているとき、それを袋 a または b から取り出した確率を求められる

- 本当は袋を選んでから玉を取り出したのに、玉が先に分かっていて袋の確率を求めている → 時間を逆行している

事前分布と事後分布

- 原因(選んだ袋)→ 結果(取り出した玉)

- Bayes の定理より、結果から原因の確率を計算できた

- 事後分布: 結果が観測された後の分布

- 事前分布: 結果が観測される前の分布

- 事前分布にトレーニングデータを与えて事後分布を求める

目次 1

- 機械学習って何?

- 線形回帰

- 分類

- その他の機械学習

- 確率の基本

- 確率分布・Bayes の定理

- 具体例 (2 つの袋の赤玉/白玉)

- 逐次推論

もっと多くの玉を取り出してみよう(1)

- 袋 a/b がわからない状態で、玉を取り出し、その結果から袋 a/b それぞれの確率を推定した

- 複数回取り出して戻す(復元抽出)すれば、より確からしい推論ができそう

- という結果が得られたとする

- 求めたいのは、

- 復元抽出は独立なので、

もっと多くの玉を取り出してみよう(2)

-

Bayes の定理より

-

ここで分母の計算が面倒 (周辺化を行う必要がある)

-

はのすべての場合について足し合わせると 1 になるので、分子のみを計算して後で合計が 1 になるように調整する ← 今後、頻出するテクです

もっと多くの玉を取り出してみよう(3)

- について

- は比例するという意味。分母を省略しているため。

- 計算略: については、, についてを得ます。(式(1.42), (1.43))

- 足して 1 になるように正規化する

逐次推論

このように複数の独立なデータがあれば、より確からしい推論を逐次的に行える。

- 1 つの観測値を得たとする。事後分布は、

- さらにもう 1 つを得たとする

目次 2

- グラフィカルモデル

- ベイズ推論の導入

- 大まかな流れ

- 線形回帰

- クラスタリング

- 意思決定

- 利点・欠点

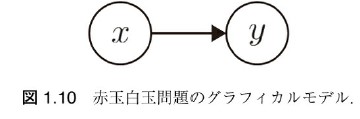

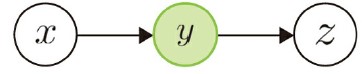

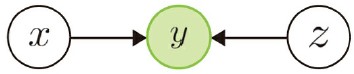

グラフィカルモデル

- モデルに出てくる変数を視覚的に理解したい

- 数式だと条件付き分布やその積がたくさん出てきて大変

- 例えば先程の例だと

- 各変数(x, y)が頂点になっている

- 辺(矢印)は条件付き分布を表す

- y の分布は x に依存している

- グラフの構造は DAG(有向非巡回グラフ): 向きがあってループなし

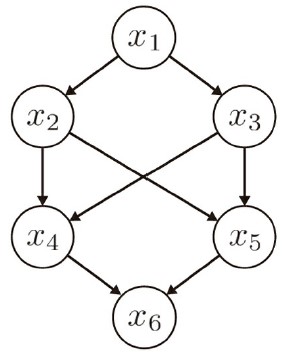

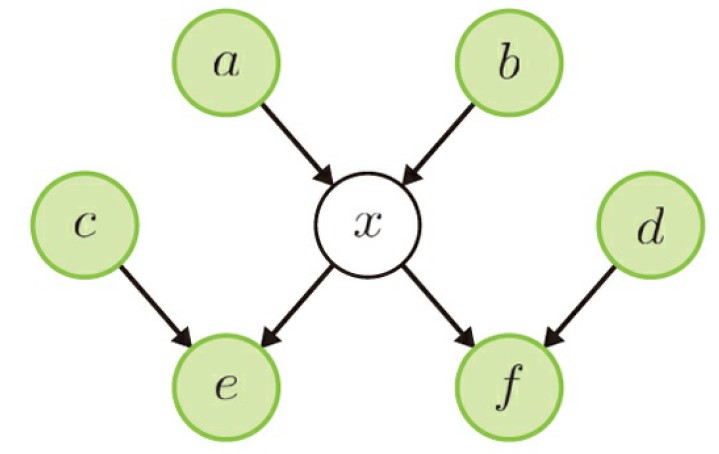

例

- グラフィカルモデル (ループが存在しないことも注意)

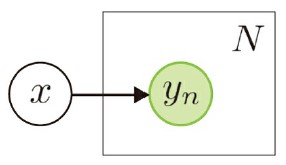

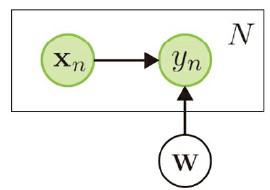

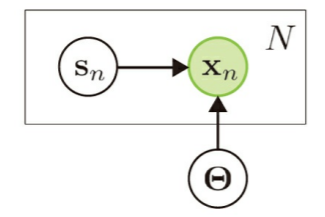

繰り返し(プレート表現)

- n 個の変数が存在するときなどに使える

- 先程の逐次推論の例では、N 回の復元抽出を行った。その全ては「袋の選択」x に依存していた。

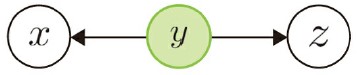

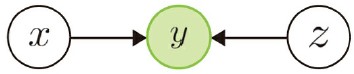

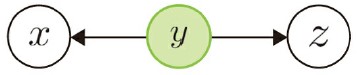

いろいろなグラフィカルモデル

- 条件付き分布の関係を視覚的に表現する道具を手に入れた

- 条件付けのタイプをグラフィカルモデルとともに見ていく

- head-to-tail

- tail-to-tail

- head-to-head

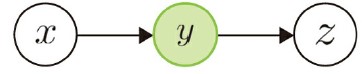

- head-to-tail

- が観測されているとして、やの事後分布を考える

head-to-tail

-

式は

事後分布は? -

もともと と の間にあった関係は が与えられたことで消えて、 と は独立になった

- 事後分布が独立に分解できる →条件付き独立性

tail-to-tail

- 式は

事後分布は? - と は条件付き独立

head-to-head

- 式は

- もともと と は独立

- 事後分布は?

- 条件付き独立にならない

- の観測によって、とに依存関係が生じてしまった

マルコフブランケット

TODO:

目次 2

- グラフィカルモデル

- ベイズ推論の導入

- 大まかな流れ

- 線形回帰

- クラスタリング

- 意思決定

- 利点・欠点

ベイズ学習の基本

- 観測データと未知の変数に関して同時分布を構築

- はモデルパラメータ

- 例えばに正規分布を仮定したなら、はとか

- 事後分布の計算

- これは解析的に求められることもあるし、近似的に求めることも

- の計算が難しい (X について周辺化しなければならない)

目次 2

- グラフィカルモデル

- ベイズ推論の導入

- 大まかな流れ

- 線形回帰

- クラスタリング

- 意思決定

- 利点・欠点

線形回帰でベイズを使ってみよう

- 具体的に「正規分布が~」などの話は抜きにして概略のみ

- 復習:

- 今は、「サンプルごとのと共通のでサンプルごとのが決まる」ことが大事

- 「誤差が正規分布に従うと仮定してー」などの話は具体的な分布について扱ってからの話

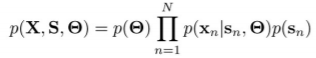

step1: 同時分布を構築する

- やは個のサンプルをまとめた行列

事後分布を求める

- 途中でとが独立であることを用いた

未知のデータに対する予測

- 未知の入力をそれに対応する予測出力をとする。

- 既知のデータを用いて学習されたパラメータの分布を用いて、未知の入力に対して期待される出力を求める

- 重要: パラメータを 1 つの値に決めるのではなく、その事後分布を求めて(学習して)周辺化するところがベイズ的

目次 2

- グラフィカルモデル

- ベイズ推論の導入

- 大まかな流れ

- 線形回帰

- クラスタリング

- 意思決定

- 利点・欠点

クラスタリング

- : 観測データ

- : クラスタの割り当て方

- : 各クラスタの性質

近似

- 事後分布の計算において、周辺化を伴うの計算は計算量的に難しい

- サンプリング

- MCMC

- ギブズサンプリング

- 変分推論

目次 2

- グラフィカルモデル

- ベイズ推論の導入

- 大まかな流れ

- 線形回帰

- クラスタリング

- 意思決定

- 利点・欠点

ベイズ推論の利点

- 一貫性のあるアプローチ

- ディープラーニングでは、このタスクにはこっちのモデルがいいけど、別なタスクには応用できないみたいなこともある

- ドメイン知識の導入が容易

- 医療者としての知識を確率モデルに反映

- 過剰適合しにくい

- 事前分布に強い仮定を置いている

- 「学習」は分布を更新しているだけ

ベイズ推論の欠点

- 数学が難しい

- その分、数学的な根拠がしっかりしている

- 計算コスト

- ディープラーニングも大概だけど

第 2 章では…

- 具体的な確率分布について見ていきます

- 事後分布や周辺分布の計算を具体的にできるようになります

- モデル選択は実際にデータ解析を行う上で非常に重要です

相談:

- 計算多めですが、どの深さまで追うべきでしょうか

- 担当はどうしますか / LT?

- 次回日程

- メンバー